Des bases immuables :

Le Web semble rivé sur les mêmes bases depuis la première bulle internet de 1995 à 2000. Outre les modes de présentation (Le flash, l’arrivée des d’un E-marketing sérieux, du contenus trois points, des carousels, puis du jquery), les fondamentaux d’un site internet se sont bien ancrés sur le long terme autour de pages de contenus desservies par un menu principal et des liens secondaires. Derrière cela on recoupe 99,9999% des sites existants. Le SEO (référencement) puis le SMO (référencement sur les réseaux sociaux) ont lissés quelque peu les usages en matière de conception technique, de la même manière que l’ergonomie du web est arrivée a maturité.

Un web lissé et uniformisé :

Un bon exemple de cela est la manière dont les sites E-commerce sont construits, pas seulement parce qu’ils utilisent les mêmes architectures à la base (Prestashop, Magento, Thélia, etc.) mais aussi parce que l’on souhaite de l’efficacité avant tout et que l’on souhaite présenter à un client le moyen de trouver rapidement ce qu’il souhaite (et d’acheter rapidement !). Un internaute qui cherche comment passer commande provoquera des abandons, de même par exemple qu’une originalité dans la présentation qui dérange comme par exemple un choix de police/fonds original mais moins lisible, etc. Des habitudes sont prises en étudiant la concurrence qui aboutissent à des modèles quasi intangibles. Les graphismes changent mais tous les liens d’interaction les plus fonctionnels pour ce type de site seront rigoureusement à leur place. Ce sont donc des impératifs de bon sens marketing qui « lissent » le web.

Une interactivité qui s’épuise :

Certes, la puissance des ordinateurs augmente, les navigateurs se modernisent, mais les médias se sont également multipliés (tablettes, iphones) et ont vite pris de bonnes part du marché. Les gagnants de ce jeu ont établi des bases standardisées dès le départ de manière à incrémenter le plus d’applications possibles, gage de leur polyvalence d’usage et donc d’intérêt durable pour les internautes. Les iphones et tablettes ont su passer de l’étape cruciale de « gadgets technologiques » à un usage quotidien accepté à part entière. Or, les technologies employées sont en nombre restreint, et doivent s’accorder avec celles régissant le monde technique du web « courant ». Après le dégonflement des possibilités du jquery du fait d’une difficile évolution technologie du navigateur encore le plus utilisé, Internet Explorer, les internautes ont tout simplement renoncé à utiliser toutes les possibilités offertes par ces scripts dérivés du javascript pour que leur contenu soit visible du plus grand nombre. (Exemple : Le fait de « glisser-déposer » intuitivement une image dans une application depuis une fenêtre de son PC au lieu de parcourir classiquement son arborescence, ou bien de pouvoir déplacer librement des objets dans l’espace de la page). Le plus grand fautif en la matière étant le lourd, typique réseau d’entreprise, qui migre beaucoup plus difficilement en particulier par temps de crise, et où se trouvent les internautes-prospects les plus intéressants !

Certes, la puissance des ordinateurs augmente, les navigateurs se modernisent, mais les médias se sont également multipliés (tablettes, iphones) et ont vite pris de bonnes part du marché. Les gagnants de ce jeu ont établi des bases standardisées dès le départ de manière à incrémenter le plus d’applications possibles, gage de leur polyvalence d’usage et donc d’intérêt durable pour les internautes. Les iphones et tablettes ont su passer de l’étape cruciale de « gadgets technologiques » à un usage quotidien accepté à part entière. Or, les technologies employées sont en nombre restreint, et doivent s’accorder avec celles régissant le monde technique du web « courant ». Après le dégonflement des possibilités du jquery du fait d’une difficile évolution technologie du navigateur encore le plus utilisé, Internet Explorer, les internautes ont tout simplement renoncé à utiliser toutes les possibilités offertes par ces scripts dérivés du javascript pour que leur contenu soit visible du plus grand nombre. (Exemple : Le fait de « glisser-déposer » intuitivement une image dans une application depuis une fenêtre de son PC au lieu de parcourir classiquement son arborescence, ou bien de pouvoir déplacer librement des objets dans l’espace de la page). Le plus grand fautif en la matière étant le lourd, typique réseau d’entreprise, qui migre beaucoup plus difficilement en particulier par temps de crise, et où se trouvent les internautes-prospects les plus intéressants !

Le second frein aux évolutions technologique du web est la complexité des sites récents qui doivent, en plus de gérer une cohorte de navigateurs aux technologies parfois limitées, intégrer un aspect « responsive » dans leur design : A savoir compatibles avec les iphones et tablettes. Enfin le poids de ces contenus purement technique (c’est du code) se fait au détriment de la vitesse d’exécution, synonyme de lenteurs d’affichage, de réponse, et de taux de rebond ou d’abandon des internautes ce qui reste évidemment rédhibitoire dans une approche E-marketing. On a tendance donc à utiliser ces effets avec parcimonie et après les avoir rigoureusement testés.

Enfin, que peut-on inventer de plus à partir d’un écran 2D ? Pas grand chose en fait. On continue à cliquer sur des liens pour accéder à des contenus ou provoquer une réponse du site. Reste que derrière cela les technologies de bases n’ont pas évolué depuis plus de vingt-cinq ans : Ce sont les même protocoles, hérités de l’ère de l’internet filaire téléphonique.

Une révolution se prépare.

Pour préciser ce titre, il ne s’agit pas de « futur » à courte portée (5-6 ans), mais bien d’anticipation à long terme. Il ne s’agit pas d’empiler les nouveautés javascripts pour tenter de rendre les usages de l’internaute encore plus ergonomiques, mais bien d’apporter une vision de l’internet totalement nouvelle. Enfin il ne s’agit pas d’une plus grande « intelligence » du web (le fameux web 3.0 ultra-sémantique) tourné vers le bénéfice des marchands qui pourront cibler leurs prospects avec encore plus de précision, mais bien d’un véritable révolution d’usage et d’apparence : L’irruption d’une vraie 3D avec les moyens de l’exploiter.

Et cette-ci va arriver de deux manières :

– Dans votre vie quotidienne, hors du bureau, sous la forme de la réalité augmentée, avec une série de lunettes (à commencer par les google glass) qui dans leur forme primitive peuvent être assimilées à des gadgets mais entraîneront rapidement une véritable révolution des usages. Il vous sera possible en effet de voir en 2d des informations sur des verres recouvrant tout votre champ de vision. Un effort mental sera nécessaire pour que les yeux assimilent ces deux réalités comme un tout et interagissent avec lui sous une forme qui reste encore à déterminer par les usages. Le feedback permis par la miniaturisation des caméras et projecteurs, le tout connecté a internet en très haut débit et alimenté par un puissant processeur, permet (déjà) de transformer n’importe quelle surface neutre en surface d’action pour y projeter des visuels ou tout éléments d’interaction comme un clavier… On peut donc par exemple composer un numéro de téléphone sur sa main et appeler. Reste à intégrer des capteurs de mouvement pour détecter la danse des mains et des doigts dans l’espace, ce qui existe déjà également à cette paire de lunette pour effectuer des actions virtuelles. Cela est pour l’instant limité à des usages scientifiques de manipulation d’objets 3d.

Le système de manipulation 3d « mains libres » créé par Elon Musk. La création aujourd’hui c’est un mix de gestuelle calibrée sur Leap Motion, casque oculus rift, et impression 3D. Les gains de productivités sont énormes.

– Dans votre vie au bureau, par cette fois la substitution de deux réalités. Celle d’une interface en 3D qui devient un nouvel environnement de travail à part entière, une réalité virtuelle « intégrale ». Celle-ci existe dans les faits à titre expérimental depuis des années et se traduit sous la forme d’un casque opaque projetant un environnement visuel et sonore cohérent en temps réel à l’utilisateur. La première application dans ce domaine se trouve dans les jeux vidéos et une société comme Oculus semble sur le point d’inaugurer un standard en la matière pour une future commercialisation massive. Or, si l’on peut modéliser un environnement 3d répliquant un environnement « réel » (ex. montagne) avec difficulté (puissance de calcul limitée) on peut à priori plus facilement répliquer une environnement de travail fonctionnel et artificiel.

L’avantage d’un tel environnement ? On utilise ses mains en entier ou partie et ses doigts (voir plus haut) pour déplacer des éléments, pointer dessus ou les faire glisser en utilisant les doigts de telle manière que les possibilités d’interaction sont bien plus étoffées qu’avec un clavier classique. Lorsque les mains et les bras sont posés sur un bureau de la même manière qu’aujourd’hui, la localisation dans l’espace est encore plus simple. On peut d’ailleurs imaginer que sur le plan technique, la « sphère d’interactivité » limitée des bras et mains sera bien localisée et facilitera le développement d’applications et la vitesse de calcul qu’avec une position debout et mouvante. Oubliez donc le ballet manuel de Tom Cruise dans « minority report », on est déjà un stade plus loin. L’autre avantage d’un environnement 3d est que vous disposez bien entendu d’un « écran » de travail et d’action potentiellement à 360°. En réalité il sera sans doute plus limité par les limites de fatigue de rotation du cou et de la fatigue oculaire liée à la vision périphérique…

La science-fiction est souvent un laboratoire d’idées sur ces sujets. Toutefois « Minority Report » de Spieleberg (2002 ) est déjà obsolète par l’usage des gants que porte Cruise pour « gratter » les images affichées en 2d. Des capteurs de clavier permettent aujourd’hui de s’en passer.

Enfin une telle interface restant virtuelle, elle serait à même d’opérer en alternance avec la réalité augmentée, grâce à des lunettes se prolongeant jusqu’aux oreilles pour l’environnement sonore et certainement moins fatigantes à porter et plus pratiques qu’un casque. On pourrait donc travailler avec la même efficacité quelque soit sa localisation physique, le travail serait donc plus « nomade » que jamais, ou bien se servir d’un environnement alternatif dans sa vie quotidienne, passant de l’un à l’autre en fonction de ses besoins et selon les avantages des deux formules. En matière de « bulle » de calcul étendue rien n’empêche en effet, après calibration physique de l’utilisateur, le même type d’interaction dans un environnement en réalité augmentée, matérialisant par exemple ses éléments d’action par superposition dans un espace réel, les manipulant au besoin avec les bras. Le futur de l’interactivité sera gesticulant et fera penser à des concours de mimiques…

Et le web dans tout ça ?

Il deviendrait logiquement un univers en accord avec ces nouveaux usages. A savoir, les sites eux-même deviendront également « panoramiques », conçus pour fonctionner à 360°, des univers semblables à des pièces dans lequel on pourra évoluer comme pour un bâtiment. Les informations s’afficheront sur les « murs » vus en perspective déformée pour une meilleure visibilité et des éléments volants. Ils seront plus interactifs que jamais. Avec la multiplication des standards de connexion (cela à commencé avec l’inscription automatique via twitter ou facebook), votre présence seule sur un site sera notée et vos paramètres pré-enregistrés. La publicité sera également plus personnalisée et fine que jamais en fonction de profils déterminés par une analyse comportementale très poussée et reposant sur des modèles types en fonction des données récoltées : La psychologie au service de la réclame.

La scène du contrôle virtuel de Zion (Matrix 3 des frères Wachowski) est sans doute encore plus proche dans sa traduction graphique de ce que seront le travail virtuel au quotidien et l’exploration du web dans les années 2025-2050.

La grande inconnue sera l’ergonomie des lieux, à savoir par exemple quels mouvements seront nécessaires pour avancer (tourner c’est induit par les mouvements naturels de la tête). Mais la plupart des actions sur des « objets » dans l’environnement seront sans doute dictées par un usage, là encore instinctifs des mains avec des objets réels, et quelques spécificités pour des actions impossibles à retranscrire de manière « naturelles ». Les webmasters ne devront donc plus être seulement des graphistes 2D mais bien 3D, de manière à pouvoir personnaliser des objets « flottants » types et d’y inscrire des fonctionnalités supplémentaires. La puissance des micro-processeurs continue à progresser, et on l’espère la standardisation forcée par la complexité croissante des sites internet vont permettre d’incrémenter e nouveaux effets bien plus impressionnants que les actuels artifices permis par le language jquery.

Enfin, ces prospectives ne doivent pas masquer deux facteurs importants : La charge imposée en terme d’échanges, de calcul et d’affichage en temps réel de ces données va nécéssiter non seulement une nouvelle technologie de développement (exit les vieux tuyaux et les solutions en javascript, php-mysql) et une puissance de calcul infiniment supérieure à ce qui existe actuellement, probablement venant de la maîtrise de l’informatique quantique.

Calibrer son poste de travail.

Concrètement l’interactivité à son poste de travail ne sera possible qu’après une phase de « calibration ». Chaque individu étant différent, il faut imaginer définir une sphère contenant des éléments virtuels sur lesquels il faudra interagir. Les coordonnées seront enregistrées pour chaque action via feedback avec la projection de manière à définir la juste position des bras et des mains par exemple. C’est un système dérivé de ce qui existe déjà dans la motion capture. Outre un clavier virtuel, cela sera sans doute la somme des interaction déjà présentes pour l’utilisation d’écrans tactiles, auxquels s’ajouteront des gestes spécifiquement optimisés pour la troisième dimension. Voyez Leap Motion qui est un logiciel pionnier en la matière, quoique encore très imparfait. Comme toutes les application pionnières on reste limité à un certain nombre d’applis compatibles, où figurent néanmoins Le New York Times et Google Earth. Un reportage lachainetechno (01net TV)

Pour aller encore plus loin

L’horizon 2025-2050 c’est bien, mais l’horizon 2100 et plus c’est mieux. Si vous avez tenu jusque là, projetons-nous donc plus loin.

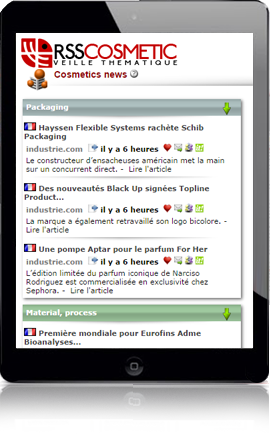

Le futur lointain du « web » sera depuis longtemps médiatiquement unifié: A vrai dire il n’y aura plus guère de séparation entre une utilisation « locale » (logiciels) et « online » (web). Les applications internet actuelles sont pour beaucoup des logiciels et la tendance en matière de complexité des sites web tend toujours vers plus de fonctionnalités, ce que nous faisons actuellement avec nos outils de veille, qui sont au départ des sites internet très améliorés (base technologiques semblables). Avec l’augmentation par un facteur de plusieurs milliards de la puissance de calcul les possibilités sont quasiment infinies. On peut très bien envisager qu’au prochain siècle, il n’y aura tout simplement plus de « jeux de mains », et ceci pour une bonne raison. La pensée va plus vite que les gestes. Plutôt que d’en passer par un clavier virtuel pour mimer le fait de taper sur des touches, il va sans dire qu’il est bien plus rapide de « dicter » mentalement un texte. En matière de télépathie les progrès sont constants aujourd’hui, notamment de manière à permettre aux paralytiques d’interagir avec leur environnement. On va donc vers un modèle d’interaction ou seule la pensée « courante » (la pensée claire qui précède immédiatement la parole), génère du contenu et interagisse, en collaboration avec la vision, sur des éléments graphiques 3D. Les gains de productivité issues d’une telle pratique seraient tout simplement faramineux. Une journée type de travail actuel de huit heure pourrait être réduite à quatre ou moins. Ce serait véritable l’âge d’or de la « civilisation des loisirs ».

Allons encore plus loin dans le temps.

A puissance de calcul surmultipliées, possibilités nouvelles, notamment la cartographie complète et en temps réel des interactions du cerveau. Quelles implications pour le web? Si on peut cartographier les interactions du cerveau on peut donc suggérer au cerveau des informations totalement factices. Cela permettrait par exemple de donner au cerveau l’illusion quasi-parfaite d’une réalité alternative (on retombe dans un scénario à la « Matrix »). Les sites web ne seraient donc que de petits univers créés de toute pièces, avec une gradation d’éléments d’apparence « réels » et d’autres purement virtuels mais fonctionnels. Mais quelle serait les implications de la vie ou du travail dans un monde totalement virtuel ? – Un gain de temps encore supérieur. En effet, en se passant des « auxiliaires » des cinq sens, alimentés à la base directement au niveau du cerveau, la rapidité du feedback entraîne une rapidité du traitement, avec auto-adaptation de l’horloge interne. Cela signifie concrètement que le temps vécu en virtuel passe deux, trois fois plus vite qu’en réel et donc permet de travailler notamment deux ou trois fois plus vite, avec les moyens vus précédemment qui font largement appel à la télépathie, mais cette fois « court-circuités ».

Au final on travaille donc bien plus rapidement encore, et bien plus efficacement qu’auparavant. Dans un univers virtuel par exemple, les contraintes d’espace-temps sont absentes, on peut assister à une réunion sans temps de transport. C’est son univers qui s’auto-adapte à ses propres besoins, et non plus le contraire. Physiquement le corps serait par contre maintenu en état d’immobilité totale proche de l’hypnose. Et le cerveau « surchauffe » et se fatigue bien plus vite dans ces conditions. On suppose donc d’une phase de travail virtuel serait suivi par un sommeil bien réel. Cela ne représentant que quelques heures à peine, le corps physique aurait alors l’essentiel du reste du jour pour travailler et ne pas perdre son équilibre naturel. Bien d’autres possibilité sont ouvertes par ce nouveau type de vie, mais là c’est le travail d’imagination des auteurs de science-fiction qui va combler les vides…

Alors, à quand la veille en 3d ?

Un sujet techno Rssintelligence.

Fire Stomp est une nouvelle gamme innovante de produits de tricots, développée et mise en place par Texollini, société basée à Long Beach en Californie, qui développe depuis des années des machines à tricoter circulaires et des tissus innovants. Dans la collection Fire Stomp™, il existe une variété de mélanges de fibres tricotées en exclusivité avec Superfino® pour la première couche. La ligne de tissus FR utilisent Viscont® FR fait de filaments rayonnants de Glanzstoff. Les nouveaux tissus Fire Stomp™ présentent un mélange de filaments rayonnants FR/Lycra en deux constructions de jersey. La collection comprend également un « mélange Quad » fait d’un autre développement propriétaire de FR modacrylique/laine/nylon de couleurs vives pour équiper les personnes travaillant sur les ponts d’envol ou le personnel de sécurité par exemple. Il y a d’autres développements avec le lainage Triblend de Texollini – ceratins avec du Lycra. Tous les produits sont conformes pour les applications FR commerciales, militaires et industrielles.

Fire Stomp est une nouvelle gamme innovante de produits de tricots, développée et mise en place par Texollini, société basée à Long Beach en Californie, qui développe depuis des années des machines à tricoter circulaires et des tissus innovants. Dans la collection Fire Stomp™, il existe une variété de mélanges de fibres tricotées en exclusivité avec Superfino® pour la première couche. La ligne de tissus FR utilisent Viscont® FR fait de filaments rayonnants de Glanzstoff. Les nouveaux tissus Fire Stomp™ présentent un mélange de filaments rayonnants FR/Lycra en deux constructions de jersey. La collection comprend également un « mélange Quad » fait d’un autre développement propriétaire de FR modacrylique/laine/nylon de couleurs vives pour équiper les personnes travaillant sur les ponts d’envol ou le personnel de sécurité par exemple. Il y a d’autres développements avec le lainage Triblend de Texollini – ceratins avec du Lycra. Tous les produits sont conformes pour les applications FR commerciales, militaires et industrielles. GlenGuard Hi-Vis Anti-Stat est un nouveau tissu introduit dans la ligne des Glen Raven Technical Fabrics. Développé conjointement avec les textiles de performance de William Barnet & Son LLC, GlenGuard Hi-Vis Anti -Stat est un produit de grande visibilité, fireproof, conformes aux normes ANSI 107, ASTM 1506 et NFPA 70. Il protège de l’électricité statique pour éviter une inflammation à partir des émanations qui peuvent être présentes sur les lieux de travail. Ce tissu empêche l’accumulation d’électricité statique grâce à l’utilisation d’une fibre de carbone développée par Barnet pour les salles blanches, les hôpitaux et toutes les vêtements de travail. Le cœur de la fibre de carbone est enveloppé dans une gaine de polyester qui protège la fibre de carbone contre l’abrasion et les dommages pendant le lavage sans diminuer les propriétés de dissipation statiques de la fibre de carbone. Le tissu est disponible dans les constructions tissés et maillés.

GlenGuard Hi-Vis Anti-Stat est un nouveau tissu introduit dans la ligne des Glen Raven Technical Fabrics. Développé conjointement avec les textiles de performance de William Barnet & Son LLC, GlenGuard Hi-Vis Anti -Stat est un produit de grande visibilité, fireproof, conformes aux normes ANSI 107, ASTM 1506 et NFPA 70. Il protège de l’électricité statique pour éviter une inflammation à partir des émanations qui peuvent être présentes sur les lieux de travail. Ce tissu empêche l’accumulation d’électricité statique grâce à l’utilisation d’une fibre de carbone développée par Barnet pour les salles blanches, les hôpitaux et toutes les vêtements de travail. Le cœur de la fibre de carbone est enveloppé dans une gaine de polyester qui protège la fibre de carbone contre l’abrasion et les dommages pendant le lavage sans diminuer les propriétés de dissipation statiques de la fibre de carbone. Le tissu est disponible dans les constructions tissés et maillés. Merino State Bi-Component Fabrics (fabriquées par l’Australien Charles Parsons & Co) sont des lainages mérinos tricotées avec les fibres innovantes «Merino Plus» et d’autres fibres de type coton biologique, Biophyl, Tencel, Modal et filaments de polyester haut de gamme. La société utilise d’intéressantes constructions de tissu tricoté pour fournir une gamme de produits polyvalents, multi-fonctionnels pour une variété d’applications outdoor de type vélo, athlétisme et chasse. Les produits bi-composants pourrait aussi se retrouver dans les sports plus traditionnels comme le golf et le tennis. Un ajout intéressant serait l’intégration de modèles de camouflage sous licence. Merino Sate travaille d’ailleurs actuellement en étroite collaboration avec Realtree et Mossy Oak pour développer des textiles spécialisés pour le marché de la chasse.

Merino State Bi-Component Fabrics (fabriquées par l’Australien Charles Parsons & Co) sont des lainages mérinos tricotées avec les fibres innovantes «Merino Plus» et d’autres fibres de type coton biologique, Biophyl, Tencel, Modal et filaments de polyester haut de gamme. La société utilise d’intéressantes constructions de tissu tricoté pour fournir une gamme de produits polyvalents, multi-fonctionnels pour une variété d’applications outdoor de type vélo, athlétisme et chasse. Les produits bi-composants pourrait aussi se retrouver dans les sports plus traditionnels comme le golf et le tennis. Un ajout intéressant serait l’intégration de modèles de camouflage sous licence. Merino Sate travaille d’ailleurs actuellement en étroite collaboration avec Realtree et Mossy Oak pour développer des textiles spécialisés pour le marché de la chasse. Polymer Cross Linked Aerogels. Les aérogels polymériques réticulés développés par le Centre de recherche Glenn de la NASA sont légers, mésoporeux, robustes et mécaniquement 100 fois plus résistants que les aérogels naturels à seulement le double de la densité. Ils sont obtenus par dépôt de polymères sur une structure d’aérogel. Les aérogels sont des matériaux à faible densité avec d’excellentes propriétés thermiques et acoustiques compte tenu de leur porosité élevée et du faible diamètre des pores. Cela les rend particulièrement intéressant pour de nombreuses applications aérospatiales et industrielles, de l’isolation des réservoirs cryogéniques, aux appareils de grande consommation en passant par la construction. Cependant, l’inconvénient principal de ces matériaux est leur fragilité. Sur le plan nanométrique, les aérogels sont constitués d’un réseau en collier – comme des perles de nanoparticules, dont les points faibles restent les liaisons interparticulaires. Renforcer ce réseau de nanoparticules augmenterait donc la résistance de la structure avec seulement une petite perte de poids et une légère diminution de la mésoporosité de la structure.

Polymer Cross Linked Aerogels. Les aérogels polymériques réticulés développés par le Centre de recherche Glenn de la NASA sont légers, mésoporeux, robustes et mécaniquement 100 fois plus résistants que les aérogels naturels à seulement le double de la densité. Ils sont obtenus par dépôt de polymères sur une structure d’aérogel. Les aérogels sont des matériaux à faible densité avec d’excellentes propriétés thermiques et acoustiques compte tenu de leur porosité élevée et du faible diamètre des pores. Cela les rend particulièrement intéressant pour de nombreuses applications aérospatiales et industrielles, de l’isolation des réservoirs cryogéniques, aux appareils de grande consommation en passant par la construction. Cependant, l’inconvénient principal de ces matériaux est leur fragilité. Sur le plan nanométrique, les aérogels sont constitués d’un réseau en collier – comme des perles de nanoparticules, dont les points faibles restent les liaisons interparticulaires. Renforcer ce réseau de nanoparticules augmenterait donc la résistance de la structure avec seulement une petite perte de poids et une légère diminution de la mésoporosité de la structure. SafeTcrete, développé par EY Technologies, est composé d’une fibre longue, plate, découpée et réorganisée dans une matrice de béton pour créer une dispersion hautement isolante. Les fibres utilisées pour réaliser SafeTcrete sont rigidifiées grâce à un enrobage par un polymère à base d’ester ou d’acrylate. La rigidité obtenue facilite la dispersion des fibres dans le béton et empêche les fibres de s’agglomérer en boules dans la suspension. L’ enrobage permet aussi à ces fibres de résister à l’absorption d’eau en agissant comme une barrière hydrophobe. L’enrobage améliorerait également la liaison entre le ciment et les fibres. En plus de posséder des fibres bien dispersées dans le béton, SafeTcrete renferme des nanoparticules de silice de façon à réduire de manière significative la perméabilité du béton, le rendant plus résistant aux agents corrosifs et protégeant mieux l’armature du béton.

SafeTcrete, développé par EY Technologies, est composé d’une fibre longue, plate, découpée et réorganisée dans une matrice de béton pour créer une dispersion hautement isolante. Les fibres utilisées pour réaliser SafeTcrete sont rigidifiées grâce à un enrobage par un polymère à base d’ester ou d’acrylate. La rigidité obtenue facilite la dispersion des fibres dans le béton et empêche les fibres de s’agglomérer en boules dans la suspension. L’ enrobage permet aussi à ces fibres de résister à l’absorption d’eau en agissant comme une barrière hydrophobe. L’enrobage améliorerait également la liaison entre le ciment et les fibres. En plus de posséder des fibres bien dispersées dans le béton, SafeTcrete renferme des nanoparticules de silice de façon à réduire de manière significative la perméabilité du béton, le rendant plus résistant aux agents corrosifs et protégeant mieux l’armature du béton. Les pots VELCRO de Peel-Away sont des produits développés par Velcro Industries et disponibles exclusivement chez les fournisseurs spécialisés en jardinage. Ils permet aux jardiniers de réussir leurs transplantations grâce à :

Les pots VELCRO de Peel-Away sont des produits développés par Velcro Industries et disponibles exclusivement chez les fournisseurs spécialisés en jardinage. Ils permet aux jardiniers de réussir leurs transplantations grâce à : Le Viscont FR – Fabriqué par Glanzstoff Industries en Rep. Tchèque, Viscont FR est le seul fil de viscose FR au monde. Viscont FR offre une résistance au feu, et des performances en termes de résistance à la fonte, de confort, de contrôle de l’humidité, de résistance à l’abrasion et de solidité encore jamais atteintes par les fibres en rayonne. Le fil possède des caractéristiques techniques inédites pour les applications militaires et industrielles, les vêtements de sécurité, les bandes textiles et le textile pour l’ameublement et la décoration. La taille des fils va de 110 à 2440 dtex. Un nouveau brevet a été déposé en novembre 2012 pour un fil hybride 100% HT FR. Viscont FR est conforme à la norme Berry et est distribué exclusivement en Amérique du Nord par ICF Mercantile LLC.

Le Viscont FR – Fabriqué par Glanzstoff Industries en Rep. Tchèque, Viscont FR est le seul fil de viscose FR au monde. Viscont FR offre une résistance au feu, et des performances en termes de résistance à la fonte, de confort, de contrôle de l’humidité, de résistance à l’abrasion et de solidité encore jamais atteintes par les fibres en rayonne. Le fil possède des caractéristiques techniques inédites pour les applications militaires et industrielles, les vêtements de sécurité, les bandes textiles et le textile pour l’ameublement et la décoration. La taille des fils va de 110 à 2440 dtex. Un nouveau brevet a été déposé en novembre 2012 pour un fil hybride 100% HT FR. Viscont FR est conforme à la norme Berry et est distribué exclusivement en Amérique du Nord par ICF Mercantile LLC.

.jpg/147812163/Barcelona_Finanse_Center_(skyline).jpg)

Les fonds affluent dans l’Internet des objets, construits autour de capteurs intelligents connectés à Internet. Mais le sens le plus riche de tous, la vision, est resté en grande partie ignoré, et utilisé dans l’industrie seulement pour une petite fraction de son potentiel. La vision est resté isolée dans un recoin technologique du développement des machines intelligentes, tandis que les autres sens avançaient rapidement.

Les fonds affluent dans l’Internet des objets, construits autour de capteurs intelligents connectés à Internet. Mais le sens le plus riche de tous, la vision, est resté en grande partie ignoré, et utilisé dans l’industrie seulement pour une petite fraction de son potentiel. La vision est resté isolée dans un recoin technologique du développement des machines intelligentes, tandis que les autres sens avançaient rapidement. Certes, la puissance des ordinateurs augmente, les navigateurs se modernisent, mais les médias se sont également multipliés (tablettes, iphones) et ont vite pris de bonnes part du marché. Les gagnants de ce jeu ont établi des bases standardisées dès le départ de manière à incrémenter le plus d’applications possibles, gage de leur polyvalence d’usage et donc d’intérêt durable pour les internautes. Les iphones et tablettes ont su passer de l’étape cruciale de « gadgets technologiques » à un usage quotidien accepté à part entière. Or, les technologies employées sont en nombre restreint, et doivent s’accorder avec celles régissant le monde technique du web « courant ». Après le dégonflement des possibilités du jquery du fait d’une difficile évolution technologie du navigateur encore le plus utilisé, Internet Explorer, les internautes ont tout simplement renoncé à utiliser toutes les possibilités offertes par ces scripts dérivés du javascript pour que leur contenu soit visible du plus grand nombre. (Exemple : Le fait de « glisser-déposer » intuitivement une image dans une application depuis une fenêtre de son PC au lieu de parcourir classiquement son arborescence, ou bien de pouvoir

Certes, la puissance des ordinateurs augmente, les navigateurs se modernisent, mais les médias se sont également multipliés (tablettes, iphones) et ont vite pris de bonnes part du marché. Les gagnants de ce jeu ont établi des bases standardisées dès le départ de manière à incrémenter le plus d’applications possibles, gage de leur polyvalence d’usage et donc d’intérêt durable pour les internautes. Les iphones et tablettes ont su passer de l’étape cruciale de « gadgets technologiques » à un usage quotidien accepté à part entière. Or, les technologies employées sont en nombre restreint, et doivent s’accorder avec celles régissant le monde technique du web « courant ». Après le dégonflement des possibilités du jquery du fait d’une difficile évolution technologie du navigateur encore le plus utilisé, Internet Explorer, les internautes ont tout simplement renoncé à utiliser toutes les possibilités offertes par ces scripts dérivés du javascript pour que leur contenu soit visible du plus grand nombre. (Exemple : Le fait de « glisser-déposer » intuitivement une image dans une application depuis une fenêtre de son PC au lieu de parcourir classiquement son arborescence, ou bien de pouvoir