SEO: Nettoyez votre site et commençez par le « Cruft » !

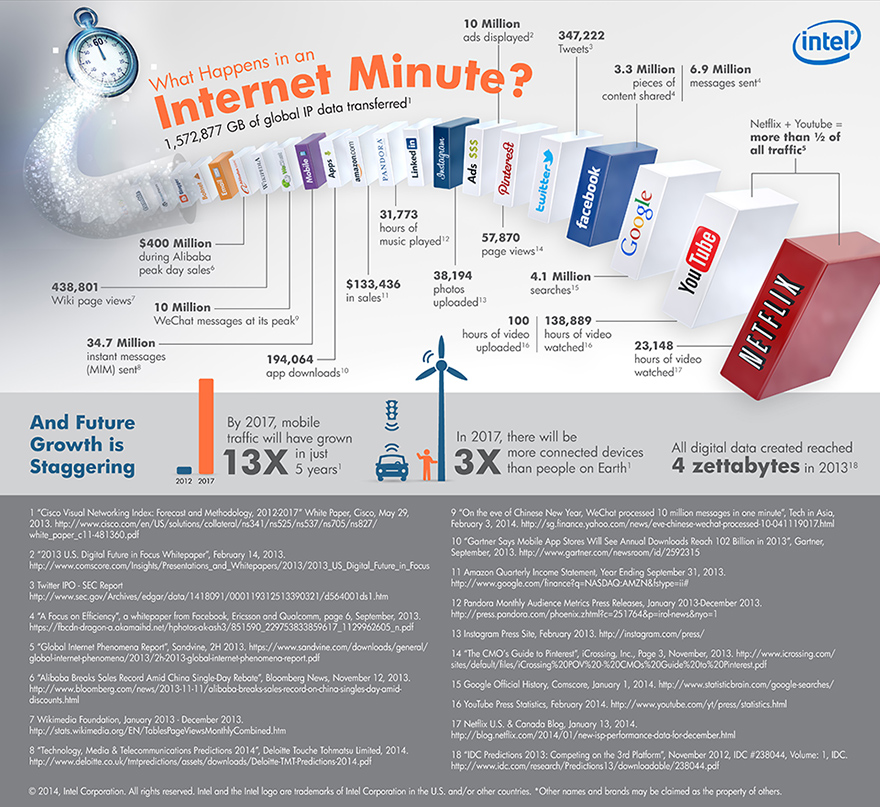

07 Sep 2015, Posté par dans DigitalL’optimisation SEO d’un site web passe par une multitude d’étapes et l’une d’elles est souvent négligée et apparait sur le long terme: Il s’agit du « cruft » que l’on pourrait vaguement traduire en Français par la « croûte ».

La définition anglophone donne: « badly designed, unnecessarily complicated, or unwanted code or software. »

Il s’agit en effet, comme pour la carène d’un navire qui aurait passé trop de temps en mer, d’une couche de choses mal gérées et pas forcément désirées ni forcément facile à voir mais qui vont à terme ralentir la vélocité du site dans les moteurs de recherche et impacter son SEO.

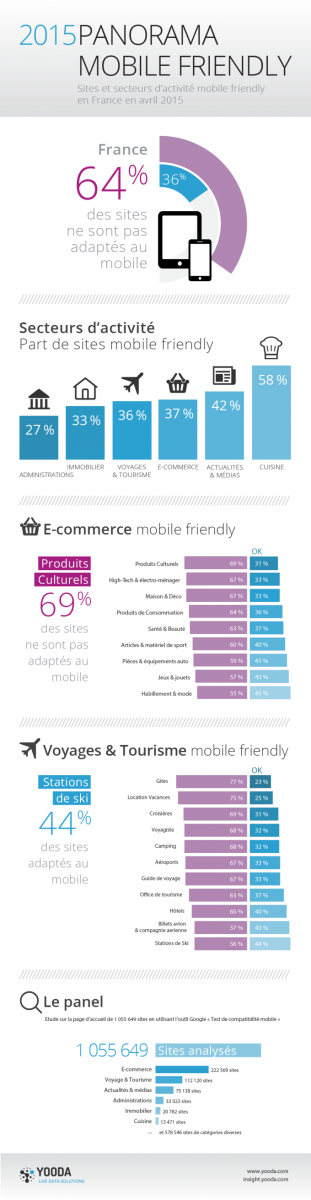

Il ne s’agit pas d’optimiser seulement le code et en corrélation la vitesse de chargement (pour minimiser le taux de rebond), mais de veiller à trouver toutes ces pages considérées par Google comme de « basse qualité », qui vont peser sur l’impression générale que donne votre site web à google.

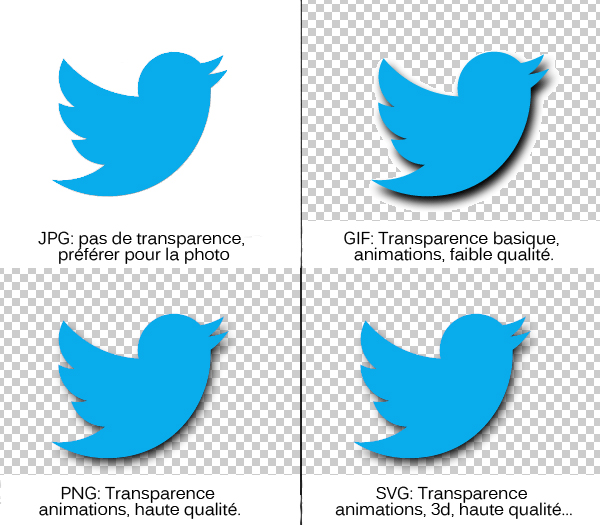

Alléger le code des pages

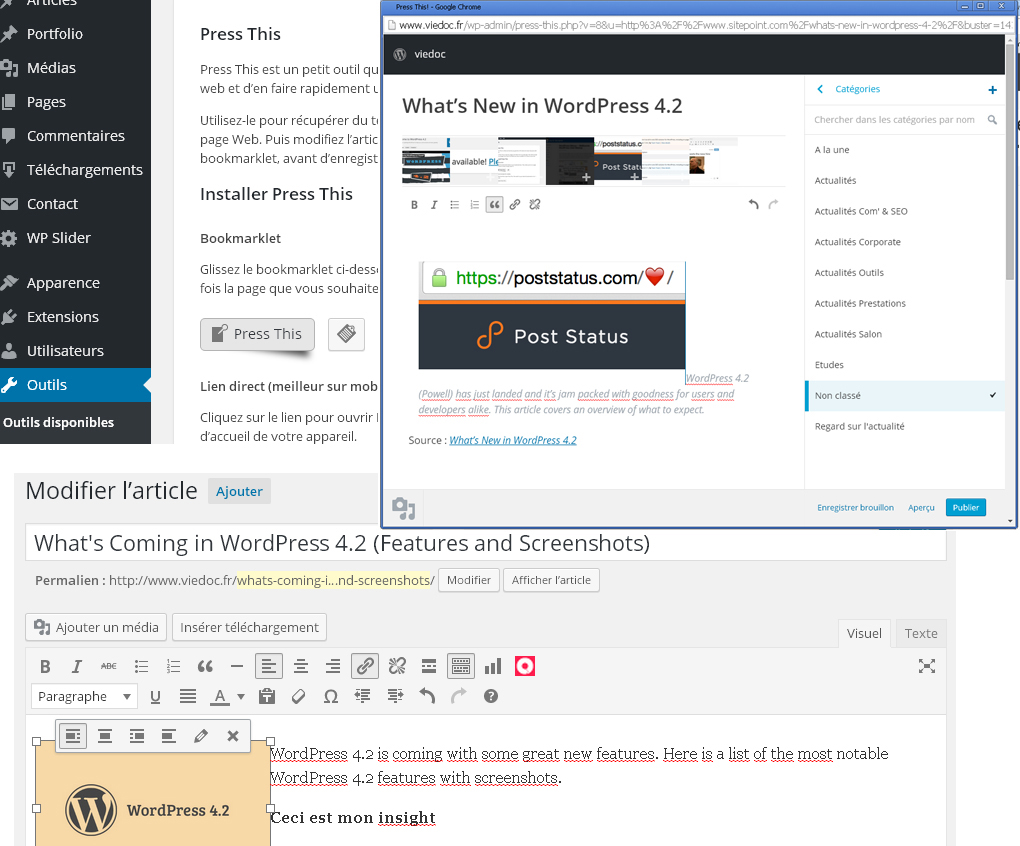

Concernant l’optimisation du code en parlant du « cruft », il faut notamment lorsque c’est possible, supprimer tous les appels et javascripts liés à des fonctionnalités périmées et/ou désactivées, mais qui sont toujours là. Un peu comme un système d’exploitation poussif qui charge des centaines d’applications jamais utilisées en pratique (suivez mon regard). Ce travail nécéssite par exemple pour un CMS de supprimer les applications purement et simplement (non de les désactiver seulement), et lorsqu’un template est présent et même mis à jour, de faire le ménage dans le code parmi toutes les applications appelées, en s’aidant par exemple d’une application d’audit navigateur. Ce ménage peut alléger jusqu’à 50% et plus du code de toutes les pages, améliorant leurs performances serveur mais aussi SEO (meilleur ratio code/texte). C’est là que l’utilisation d’un site développé sur mesure devient intéressante car il n’y a pas de « couches multiples » (CMS de base + template + plugins). Le site peut être allégé à l’essentiel « en soufflerie ».

Alléger les appels

Typiquement deux types d’appels présents sur la plupart des sites méritent l’attention: Les appels CSS (style) et Javascript. Dans les deux cas, l’accumulation de plugins extérieurs finit par nuire à la rapidité d’éxécution des pages car ces différentes pages .css et .js (javascript) appelées localement (ou pire, extérieures au site! -bibliothèque boostrap, etc.) contiennent souvent des tartines de code qui ne vont pas s’appliquer aux contenus mais sont quand même crawlés et chargés. Il convient donc, par exemple en se servant de l’audit navigateur (mozilla et Google ont des plugins assez utiles pour cela) de déterminer les optimisations possibles. cela passe le plus souvent par la fusion de toutes les feuilles de styles de vos différentes applications en une seule, tout en se débarrassant des lignes non nécéssaires, qu’il s’agissent de version minifiées ou non. De même pour le javascript, l’ensemble des scripts peuvent être regroupés; Plus en aval, sur le header du site, beaucoup de scripts peuvent être supprimés et reportés uniquement sur les pages qui en ont besoin… (ex. page avec un carousel, un formulaire en java, un compteur, ect…).

Faire la chasse aux pages de basse qualité

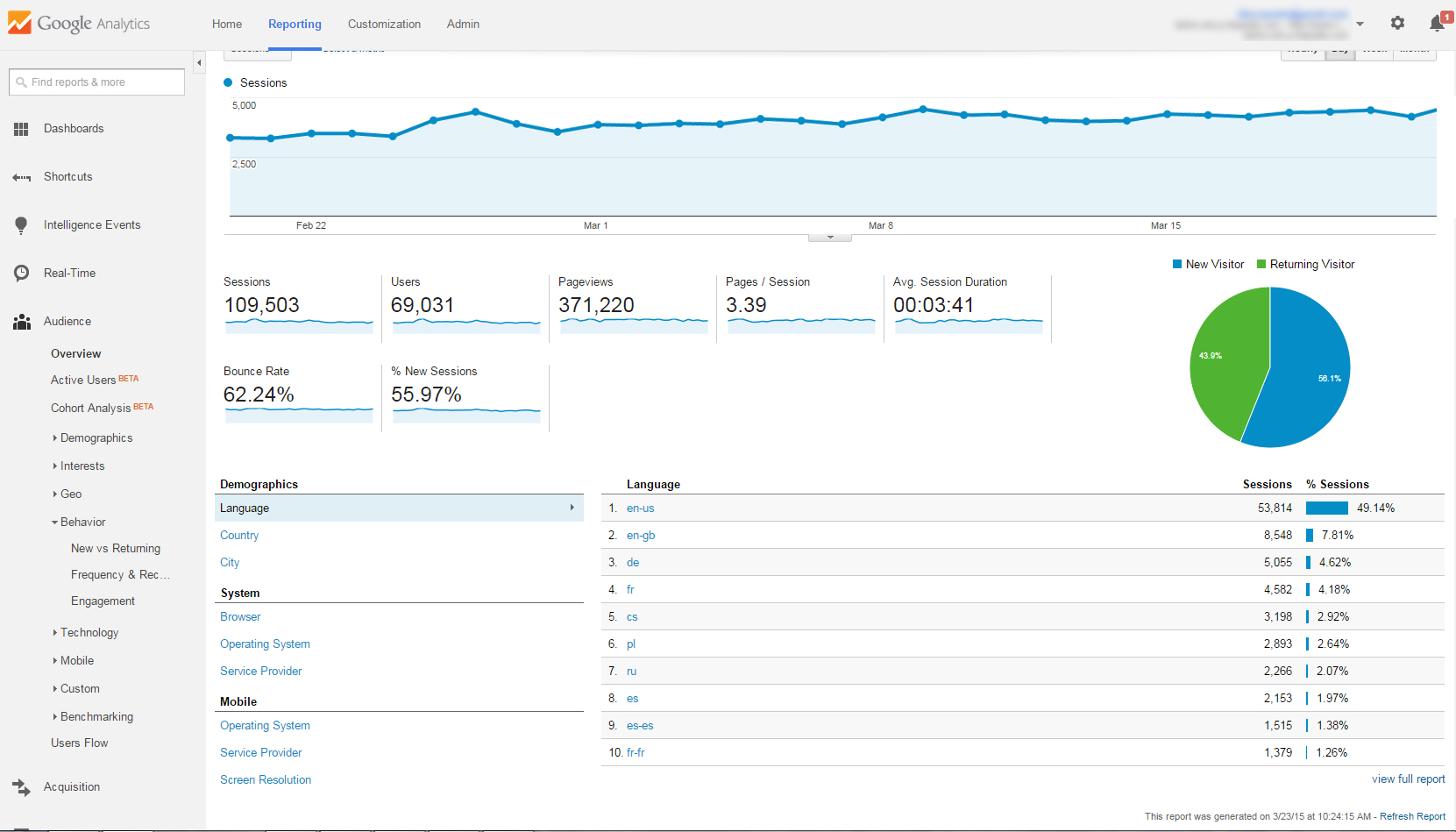

L’exemple typique est ces pages ajoutées mécaniquement avec la création de catégories. Un court texte introductif/meta et des liens, voir rien du tout sinon un titre non optimisé sous une URL non-optimisée. Cela peut être aussi des pages de contenu « normales » qui n’ont pas fait l’objet d’un grand travail et qui ont reçu (et continuent de recevoir) des faibles visites et retour. Le taux de rebond et d’engagement global permet de les identifier assez rapidement. Quelques sacrifices sont préférables lorsqu’il s’agit de préférer la qualité à la quantité. Serait-il possible de regrouper ces différents articles sur une page unique mieux optimisée ? A voir, de même que le « recyclage »: Pourquoi ne pas tenter d’améliorer ces articles en même temps, rafraîchir les informations, puis de les relancer sur les réseaux sociaux avec une approche différente ?

Au final sachez que l’agorythme Panda (de Google) effectue une balance globale du site, pesant le nombre d’articles par rapport à leur réception… Mieux vaut lui présenter moins d’articles mais ayant objectivement un contenu plus intérressant, plus fouillé, complet, et avec un plus fort potentiel de réception/partage final.

Faire la chasse au duplicate content ou NDC

Le NDC pour « near-duplicate content » ou contenu quasi-dupliqué est une constante pour les gros CMS avc des fonctionnalités sous forme de tags, pages de recherches, catégories, etc. qui sont souvent générées par les robots et donc crawlées mais vides pour l’essentiel ou n’ayant que de rares liens. 90% et plus du contenu est donc identique aux pages générées de la même manière, générant en pratique du quasi duplicate content. A la longue ce genre de pages technique automatiquement créées finissent par s’acculmuler et impact l’ensemble du site par leur seule présence. Ces pages sont typiquement « sous la lighe de flottaison », difficiles à voir.

Comment les détecter ?

Les solutions passent par des logiciels d’audit comme Screaming Frog, Onpage.org, ou tout simplement Google Webmaster Tools croisé avec Google analytics; Filtrer par taux de rebond permet notamment de vite identifier ces pages, même si d’autres filtres sémantiques fonctionnent bien.

Comment ensuite les traiter ?

– Les exclure du fichier XML (sitemap) lorsqu’il est généré automatiquement ou manuellement périodiquement (via un logicel comme XML-generator)

– En cas de duplicate/near-duplicate faire une redirection canonique

– Lien 301 ou même 404 si ces pages n’apportent absolument rien au visiteur

– Noindex/Nofollow dans le fichier robots.txt

Bon nettoyage de rentrée !